Sztuczna inteligencja to obecnie bardzo modne zagadnienie – ale czy będzie ona miała wpływ na nasze pojazdy i mobilność w przyszłości? A może już ma? I o co w tym właściwie chodzi?

Technologia określana powszechnie mianem sztucznej inteligencji zrobiła w ciągu ostatnich kilkunastu miesięcy zawrotną karierę. Dzięki takim programom jak ChatGPT praktycznie każdy może w pewnym stopniu rozmawiać ze swoim komputerem na prawie wszystkie tematy: od poszukiwania prostych pomysłów na obiad po zaskakująco dokładne odpowiedzi na zagadnienia naukowe.

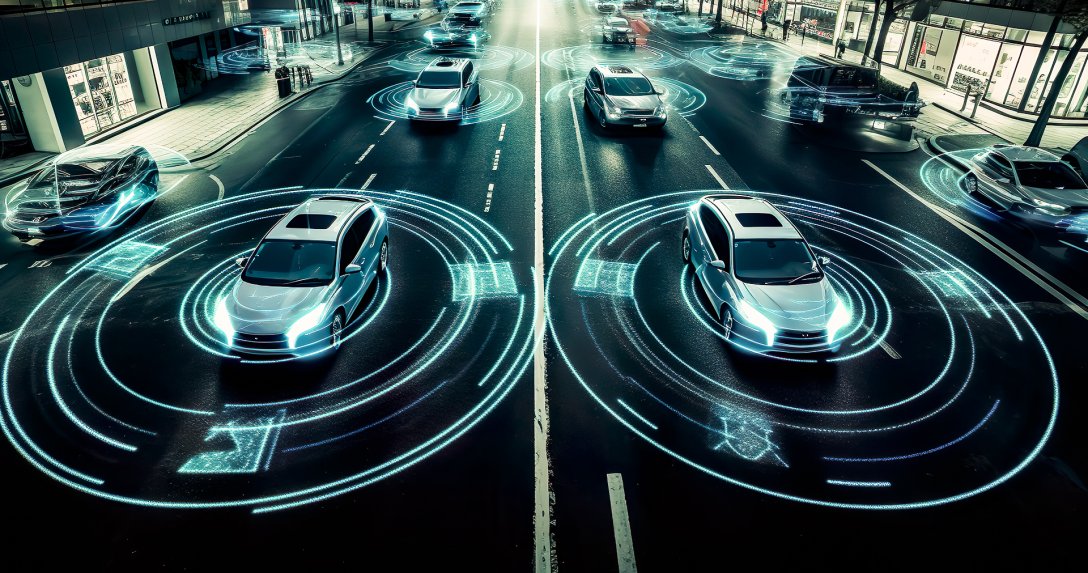

A jest to tylko jeden z dostępnych algorytmów. Sztuczna inteligencja radzi sobie bardzo dobrze choćby z generowaniem obrazów (wszystkie ilustracje do tego materiału zostały wygenerowane z udziałem AI) czy zagadnieniami związanymi z projektowaniem konstrukcji. Jaki może to mieć wpływ na motoryzację?

Maszyny nie są inteligentne i nie potrafią myśleć. To zawsze pozostaje w gestii ludzi. Niemniej jednak systemy komputerowe, także w samochodach, stają się coraz bardziej złożone, wydajne i inteligentne. Wraz z postępem cyfryzacji maszyny zdobywają dodatkowe umiejętności, które dotychczas były zastrzeżone tylko dla ludzi. Są to przede wszystkim:

Podstawą sztucznej inteligencji są tzw. sieci neuronowe, znane z badań nad mózgiem. Są one zdolne do przeszukiwania ogromnych ilości nieustrukturyzowanych danych w poszukiwaniu wzorców.

Jednakże ogólnie chodzi tutaj o systemy techniczne, które są tak dobre, jak zostały zaprojektowane, zbudowane, nauczone i szkolone przez ludzi. Niemniej jednak w tej ewolucji coraz większą rolę odgrywa samodzielne funkcjonowanie. W ciągu ostatnich lat ten autonomiczny rozwój nabrał znacznej prędkości.

Dojrzałe systemy techniczne aktywnie postrzegają swoje otoczenie. Za pomocą zaawansowanych czujników gromadzą wszystkie informacje potrzebne do realizacji danego celu. Zebrane dzięki tym technicznym oczom, nosom i uszom sygnały są przetwarzane przez maszyny – technologia uczy się radzić sobie z danymi i wyciągać z nich wnioski. Po porównaniu z zaprogramowaną bazą danych i instrukcjami system podejmuje konkretne działanie. Może on dostosować się do zmieniających się warunków w krótkim czasie i pracować autonomicznie. To otwiera dotąd nieznane możliwości, ale także rodzi pewne zagrożenia.

Gorzka strona przyszłości, a właściwie już teraźniejszości: roboty sterowane sztuczną inteligencją zastępują dużą cześć „ludzkiej” siły roboczej, na przykład w produkcji aut.

Dzięki „cyfrowej technologii wyższego rzędu” rozwiązywanie skomplikowanych problemów staje się możliwe w nieznanym dotąd tempie, oprócz automatyzacji powtarzających się procesów. Decyzje w wielu dziedzinach, podejmowane z wykorzystaniem AI, często podejmowane są bardziej obiektywnie niż te podejmowane wyłącznie przez człowieka. Szczególnie wtedy, gdy decydent ludzki ma mniej wiedzy lub mniejszą bazę danych niż profesjonalnie przeszkolona sztuczna inteligencja. Często dzieje się to, gdy nowicjusz zostaje „wrzucony na głęboką wodę” lub gdy człowiek jest rozproszony, może też mieć „zły dzień”.

Sztuczna inteligencja nie ma kaprysów. Szczególnie ważne jest to w pracy w urzędach, spersonalizowanych usługach, ale także w diagnostyce medycznej, prognozach meteorologicznych czy zadaniach optymalizacyjnych związanych z ruchem drogowym.

Sztuczna inteligencja może znaleźć zastosowanie w wielu obszarach, które doprowadzą do rozwojowego skoku, szczególnie we wciąż budzących duże zainteresowanie, ale i kontrowersje projektach przyszłości, takich jak np. autonomiczna jazda.

W obecnych początkach inteligentne rozwiązania programowe, jak ChatGPT, Jasper czy Neuroflash, pokazują, jak szybko, wszechstronnie i różnorodnie chatboty i inne technologie mogą zrewolucjonizować nasze codzienne życie i pracę. To samo dotyczy generatorów obrazów i wideo opartych na AI, a także tłumaczy równoległych. Te ostatnie mogą tłumaczyć skomplikowane rozmowy między ludźmi posługującymi się różnymi językami w czasie rzeczywistym, zachowując przy tym zdumiewającą jakość. Co jeszcze ważniejsze, coraz szybszy rozwój maszyn rodzi powszechną świadomość potrzeby kontroli i by unikać błędów, ich praca jest poddawana zintegrowanym procedurom testowym.

Powoli będziemy stawać się zależni od systemów AI. To samo w sobie niesie potencjalne ryzyko: gdy maszyny projektują maszyny, programy optymalizują się same, a następnie tworzą zupełnie nowe oprogramowanie, które może nawet przekraczać zdolności myślowe swoich twórców, powinniśmy być czujni. Czy coś takiego, jak „pokonanie” przez maszynę ludzkich zdolności w ogóle może mieć miejsce? Tak, ale czy tego chcemy? I czy możemy zatrzymać raz rozpoczęty proces? To pytania, na które jeszcze nie ma odpowiedzi.

AI może również być nadużywana. Jeśli jest to celowe, mówimy o przestępstwie. Przeciwko takiemu nadużyciu należy wprowadzić przepisy prawne. Jednak jeśli dzieje się to niezamierzenie, może to prowadzić do problemów, społecznego niezadowolenia i dyskryminacji – na przykład w przypadku weryfikowania ofert pracy, przyznawania kredytów czy rozdzielania zamówień dostawcom.

Szczególnie w przemyśle samochodowym delikatny obszar związanego z nim biznesu z branżą dostaw jest istotny dla innowacji i indywidualizacji. Decyzje ludzkie powinny nadal odgrywać kluczową rolę. Wyczucie i ocena nowych technologii, trendów, zwrotów w czasie i perspektyw przyszłości nie powinny być powierzane systemom komputerowym, maszynom ani algorytmom. Wciąż potrzebne są ludzka odpowiedzialność, zdrowy rozsądek i pomysłowość.

Tak – i to mnóstwo. Wytyczanie granic między procesami opartymi na uczeniu maszynowym, sztucznej inteligencji a decyzjami ludzkimi staje się coraz bardziej skomplikowane. Jednoznaczne granice muszą być wyznaczane zawsze tam, gdzie chodzi o bezpieczeństwo i dobro jednostek. Tylko w ten sposób można zachować odpowiedzialność, która jest warunkiem naszego społecznego współżycia.

Oczywiście w pewnym momencie systemy AI będą zdolne do podejmowania moralnych decyzji, na przykład w przypadku nieuniknionych wypadków. Jednak jak zadecydują, gdy dojdzie do sytuacji bez wyjścia? Kto ma prawo przeżyć? Społeczeństwo musi tutaj określić standardy etyczne. W żadnym wypadku nie może dochodzić do zestawień liczby i wieku potencjalnych ofiar (emeryt kontra kilkoro dzieci szkolnych), pod uwagę nie może też być brana hierarchiczna pozycja w społeczeństwie (lekarz kontra bezdomny). Zamiast tego naukowcy, technicy, humaniści i filozofowie powinni w ramach interdyscyplinarnego dialogu stworzyć niepozostawiający obszaru do dyskusji katalog moralnych zasad do „przekazania” AI. Jednak nie widać jeszcze satysfakcjonujący rozwiązań.

Krótko? AI tego nie zna, a „czynnik ludzki” sam jeszcze nie doszedł do consensusu w tej sprawie. Dla wszystkich obszarów sztucznej inteligencji istnieje podstawowy problem: systemy AI działają głównie przez zbieranie, analizowanie oraz ocenianie dużych ilości danych.

Skąd pochodzą te dane? W większości przypadków nawet w minimalnym stopniu ich źródła nie są dokumentowane. Nie można tego zrobić, ponieważ systemowo przetwarzane jest zbyt wiele danych.

Jednakże, zwłaszcza przy użyciu AI w samochodzie, na przykład w autonomicznej jeździe, dane treningowe już zawierają ogromne ilości prywatnych informacji. To utrzymuje się podczas użytkowania – ponieważ, podobnie jak ludzie, sztuczna inteligencja uczy się przez cały czas, aby następnym razem, gdy pojawi się podobna sytuacja, do już raz przez nią „przeżytej”, mogła reagować szybciej, lepiej i dokładniej.

Ogólnie rzecz biorąc, przetwarzanie tego typu danych powinno jednak spełniać wymagania Ogólnego Rozporządzenia o Ochronie Danych (RODO) Unii Europejskiej.

Jeśli chodzi o szeroko rozumiany obszar prawa autorskiego, uczymy się, z jakimi komplikacjami musimy się liczyć. Nasze społeczne roszczenia do zapewnienia praw do własności intelektualnej i zagwarantowanej indywidualności wydają się nie pasować do tej nowej epoki postępu. Ale będą musiały się do niej dostosować.

Lista możliwości zastosowania już jest długa i w ciągu najbliższych lat będzie się tylko wydłużać. Dlatego tutaj tylko kilka typowych przykładów:

Żadna obecnie znana technologia nie jest całkowicie odporna na ataki hakerów. Wraz z coraz większym użyciem sztucznej inteligencji można spodziewać się wzrostu ataków cybernetycznych. Im bardziej zaawansowana jest integracja różnych systemów w samochodzie, tym więcej grozi im niebezpieczeństw. Manipulacja, sabotaż oraz powodowanie wypadków są trudne do wykluczenia.

Jednak sztuczna inteligencja może być również wykorzystana do obrony przed tego rodzaju scenariuszami. Dzięki błyskawicznej cyfrowej komunikacji i skrupulatnej pracy systemów komputerowych eliminacja wycieków jest szybsza niż w tradycyjnych strukturach.

Tu pojawiają się szybko myśli o filmach science fiction, które wydają się teraz mniej abstrakcyjne. Systemy sztucznej inteligencji mogą – przynajmniej teoretycznie – stać się autonomiczne. Naukowcy od dawna rozwijają hipotezy dotyczące sztucznej inteligencji, która będzie przewyższała ludzki umysł.

Wydaje się jasne, że tzw. superinteligencja niesie za sobą ogromne szanse, ale również duże zagrożenia. Jeśli pewnego dnia superinteligencja uzna, że przetrwanie naszej gatunku stanowi większe ryzyko niż korzyść, istnienie ludzkości mogłoby być fundamentalnie zagrożone. Jednak także utrata kontroli przez ludzi, nadużycie superinteligencji przez jednostki lub grupy przestępcze czy ogólny konflikt wartości mogą stanowić egzystencjalne zagrożenie dla ludzkości.

Potencjalne ryzyka związane z inteligencją maszynową muszą zostać zredukowane poprzez ludzką kreatywność, odpowiedzialność i etykę. To rzeczywiście ogromne, ale z pewnością nie pierwsze wyzwanie, któremu ludzkość musi sprostać.